Что такое deepfake. Как работает эта технология и что от нее ожидать.

Вот антиутопический сценарий, который можно представить. Что, если видеодоказательства больше не являются надежными?

Что, если программа искусственного интеллекта обладает способностью наклеивать лица реальных людей на тела других людей. Заставлять их говорить, делать и выражать эмоции, которые они никогда бы не сделали в реальной жизни?

К сожалению, эта так называемая технология “deepfake” реальна. И если для вас это звучит как кошмар, вы не одиноки.

Правительства, организации и невинные люди по всему миру тоже обеспокоены. Как ни ужасно, реалистичные подделки становится все проще создавать. Им не требуется команда обученных художников. Ничего, кроме полного непрофессионала и компьютера.

И в обществе, которое полагается на правду, факты и доказательства эта технология представляет реальный риск. Если оно не научится видеть разницу между тем, что реально, и тем, что фальшиво.

Так что же такое deepfake?

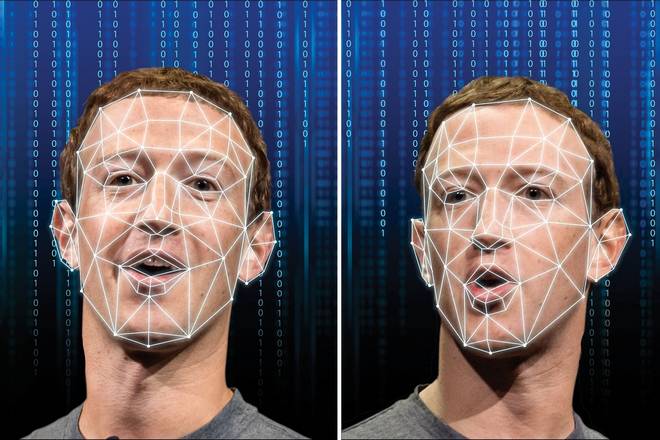

Deepfake – это новая технология искусственного интеллекта. В которой компьютеры способны выполнять реалистичные замены людей в видеоматериалах. Накладывая лицо одного человека и/или голос, на тело другого человека. Эффект может выглядеть почти бесшовным для нетренированного глаза.

Создавая пугающе правдоподобные клипы, которые выглядят реальными, но совсем не реальны. Конечно, Голливуд веками совершенствовал подобные технологии. Разница здесь в том, что для создания deepfake не требуется команда, студия или миллионы долларов. Любой человек в Интернете может скачать программу и снимать видео в свободное время. Так как сама технология выполняет большую часть работы.

Почему это опасно? Представьте себе, человек снимает на видео, как вы говорите или делаете что-то, чего вы никогда бы не сделали. Еще хуже, представьте, что на видео политический деятель, делающий противоречивые заявления.

Важно то, что людям нужно знать о deepfake сейчас и научиться быть более осторожными в том, чему они доверяют. Прежде чем технология широко распространится.

Как работает эта безумная технология?

Еще один пугающий аспект технологии deepfake заключается в том, что это не происходит в секретных лабораториях и не требует множества сотрудников.

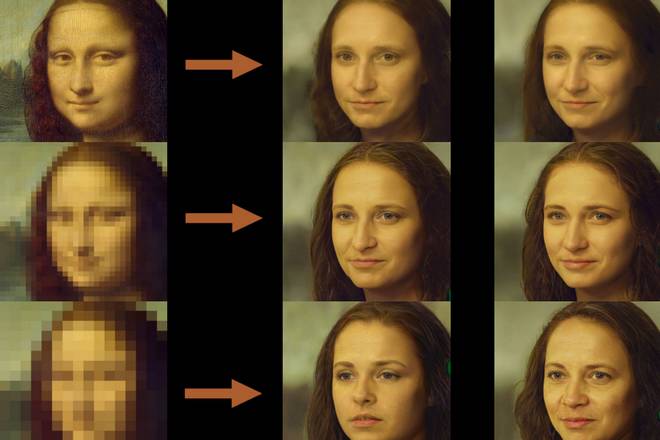

По сути, deepfakes создаются с использованием GAN, или Генеративной состязательной сети. Типа архитектуры машинного обучения, которая принимает большой объем данных. Обрабатывает их и учится генерировать новые образы на основе этих данных.

Так, например, если бы вы ввели огромное количество собственных видеоматериалов. Программа в течение нескольких часов, дней и/или недель изучит все о ваших движениях лица, манерах и образе речи. Пока в конечном итоге не сможет воспроизвести вас достаточно хорошо. Чтобы создать видео, которое убедительно похоже на реальное.

Технология становится вирусной

Как только в 2017 году начались публикации deepfake видео, прошло совсем немного времени, прежде чем явление приобрело масштабный характер. К началу 2018 года сообщество последователей технологии насчитывало 15 000 подписчиков…

Вскоре было разработано простое в использовании приложение под названием FakeApp. Предназначенное для того, чтобы обычным непрограммистам было проще создавать свои собственные видео с deepfake. Это предсказуемо привело к тому, что все больше знаменитостей женского пола встречали свои лица в откровенных сценах. В которых они не участвовали.

Индустрия развлечений для взрослых очень расстроилась по этому поводу. Хотя контент, который они создают, всегда будет спорным. Предполагается, что все зависит от согласия. Однако вопрос о том, что может сделать любой человек с этими видео, сложен.

В то время как знаменитости могут попросить студии развлечений для взрослых удалить их видео. Эти студии заявили, что они будут полностью сотрудничать. Однако это не обязательно остановит распространение таких видео.

Последствия deepfake

Помимо знаменитостей, что, если брошенный любовник создал подделку своего бывшего партнера в качестве мести? Что, если подделка будет вам стоить собеседования на работу? Или, что, если кто-то использовал технологию deepfake в целях шантажа? Это серьезные проблемы.

Также проблематичной является вероятная вероятность того, что deepfakes вскоре будут использоваться для искажения публичных деятелей. Например, когда интервью конгрессвумен Александрии Окасио Кортес в 2018 году было вырезано и склеено. Чтобы создать ложное впечатление, что она не знала ответов на простые вопросы.

Человечество уже более века считает аудио-и видеотехнологии окончательным доказательством реальности. Видео – это правда. Сегодня, в расколотом обществе, где некоторые люди считают, что мир плоский. Другие отказываются признавать существование катастрофических трагедий в реальной жизни, таких как Холокост. И даже общественные деятели говорят откровенную ложь, утверждая, что они являются “альтернативными фактами”.

Прямо сейчас, если общественность быстро не узнает о фальшивках и не научится распознавать их, распространение причудливых теорий заговора будет только нарастать.

Помимо глобальных последствий, это может быть использовано для вполне конкретных способов мошейничества. Вот как это может происходить. Во-первых, вор обучит программу искусственного интеллекта воспроизводить звук голоса директора. Будь то взятый образец из видео на YouTube, или телефонного звонка. Затем этот вор будет использовать обработанную версию голоса. Чтобы позвонить финансовому сотруднику и потребовать немедленного перевода денег … прямо в карман вора.

Как бы глупо ни звучал этот процесс. Фирма по кибербезопасности Symantec предупредила, что три компании уже были пойманы на этой афере. В результате чего были украдены миллионы долларов.

Как распознать подделку (и можете ли вы)?

Стоит надеяться, что в какой-то момент широкий круг исследователей, поймет, как распознавать deepfake. Тем временем ваш долг, и долг всех, тренировать свои глаза. Чтобы различать разницу между настоящими кадрами и подделками.

Как же учится? Лучший способ – это смотреть много deepfake. Например, оглянитесь назад на распространение ретуши Adobe Photoshop за последнее десятилетие. С течением лет вы, вероятно, научились распознавать поддельные фотографии. Будь то по определенным признакам. Или по тому факту, что картинка просто выглядит как-то “не так”.

То же самое относится и к deepfake. Чем больше вы их смотрите, тем больше ваш мозг начинает автоматически улавливать явные признаки того, что это не настоящие кадры. Движения губ выглядят неправильно. Грани расположены под неправильным углом. Все это создает эффект, который трудно определить, но невозможно не заметить … До тех пор, пока вы обращаете на это внимание.

При работе deepfake в режиме реального времени несовершенность текущего уровня технологии дает вам шанс распознать подделку с помощью нехитрого приема. Просто попросите вашего “виртуального” собеседника сделать несколько быстрых движений лицом или мимики. Видео будет иметь явно заметные дефекты, по которым можно определить, что на вашем экране deepfake.

В широком масштабе обществу необходимо быстро научиться обращаться с видеоматериалами со скептическим отношением. С которым оно в настоящее время относятся к фотографиям.

Ученые работают над этим

Ученые видят надвигающуюся на горизонте бурю, и поэтому они работают, чтобы найти способы легче перехитрить и разоблачить deepfake. Разрабатывая новые технологии и программы для их выявления.

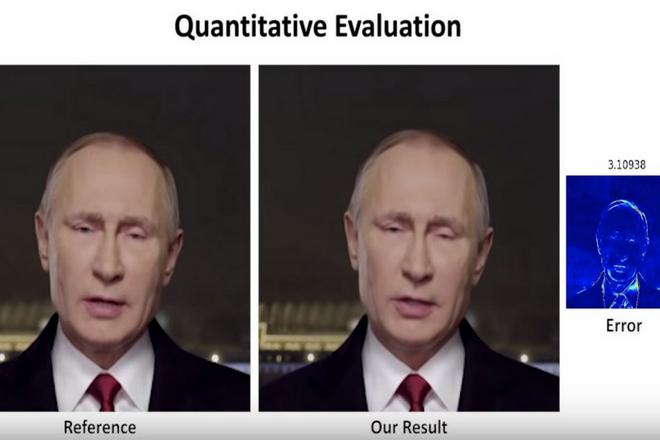

Проводятся исследования по созданию нового программного обеспечения. Которое с помощью искусственного интеллекта может разоблачать подделки с точностью 96 процентов. Это довольно хорошо.

Однако, хотя исследователи считают, что на данный момент они намного опережают технологию подделок. Они предупреждают, что текущая технология будет только совершенствоваться. И, как и в случае с угрозами взлома сегодня, мошенничество с deepfake, вероятно, станет частью постоянной “гонки вооружений”.